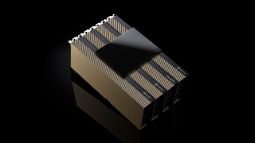

NVIDIA H200 NVL 141GB

Generative AI ve HPC İş Yükleri için Devrim Niteliğinde GPU

Teknik Özellikleri İncele

Geleceğin AI Teknolojisi

NVIDIA H200 NVL Tensor Core GPU, HBM3e belleğe sahip ilk GPU olarak generative AI ve büyük dil modellerinin (LLM) hızlandırılmasını sağlarken, HPC iş yükleri için bilimsel hesaplamaları ileriye taşıyor.

NVIDIA Hopper™ mimarisine dayanan H200 NVL, 141 gigabayt HBM3e bellek ve 4.8 terabayt/saniye bellek bant genişliği sunarak H100'den %40 daha fazla bellek kapasitesi ve %20 daha yüksek bant genişliği sağlıyor.

- 141GB HBM3e bellek kapasitesi

- 4.8TB/s bellek bant genişliği

- H100 NVL'e göre %70 daha hızlı LLM inference

- HPC uygulamalarda %30 daha yüksek performans

- 600W güç tüketimi ile enerji verimliliği

- PCIe 5.0 x16 arayüzü

- 2-yol veya 4-yol NVLink desteği

- 5 yıl NVIDIA AI Enterprise lisansı dahil

Teknik Özellikler

GPU Özellikleri

| GPU | NVIDIA H200 NVL |

| Mimari | NVIDIA Hopper™ |

| İşlem Teknolojisi | TSMC 5nm |

| Transistör Sayısı | 80 Milyar |

| Die Boyutu | 814 mm² |

| CUDA Cores | 16,896 |

| Tensor Cores | 528 (4. Nesil) |

| RT Cores | - |

Bellek Özellikleri

| Bellek Boyutu | 141GB |

| Bellek Tipi | HBM3e |

| Bellek Arayüzü | 6144-bit |

| Bellek Hızı | 1593 MHz |

| Bellek Bant Genişliği | 4.8 TB/s |

| L2 Cache | 50 MB |

Performans

| Base Clock | 1365 MHz |

| Boost Clock | 1785 MHz |

| FP32 Performans | 67 TFLOPS |

| FP64 Performans | 34 TFLOPS |

| Tensor (FP16) | 1,979 TFLOPS |

| Tensor (FP8) | 3,958 TFLOPS |

| INT8 | 3,958 TOPS |

Güç ve Bağlantı

| TDP | 600W |

| Güç Konnektörü | 8-pin EPS |

| Arayüz | PCIe 5.0 x16 |

| NVLink | 4. Nesil, 900 GB/s |

| Form Factor | Dual-slot |

| Boyutlar | 267 x 111 mm |

| Soğutma | Pasif (Sunucu) |

| Display Çıkışı | Yok |

Yazılım Desteği

| CUDA | 12.x |

| OpenCL | 3.0 |

| DirectCompute | 5.0 |

| AI Framework | TensorFlow, PyTorch |

| NVIDIA AI Enterprise | 5 yıl dahil |

| NIM Microservices | Desteklenir |

| Confidential Computing | Desteklenir |

Video Codec

| NVENC | - |

| NVDEC | 7x AV1, H.264, H.265 |

| JPEG Decode | 7x |

| VP9 Decode | Desteklenir |

| AV1 Decode | Desteklenir |

Performans Avantajları

(H100 NVL vs)

(H100 NVL vs)

(A100 vs)

Kapasitesi

Uygulama Alanları

Generative AI

Büyük dil modelleri (LLM), GPT, ChatGPT benzeri uygulamalar için optimum performans

Machine Learning

Deep learning model eğitimi, neural network training ve AI model geliştirme

Bilimsel Hesaplama

HPC simülasyonları, moleküler dinamik, fizik ve mühendislik hesaplamaları

Veri Analizi

Büyük veri işleme, data mining, istatistiksel analiz ve veri görselleştirme

Medikal AI

Tıbbi görüntü analizi, hastalık teşhisi, ilaç keşfi ve genomik araştırmalar

tarafından geliştirilmiştir.

tarafından geliştirilmiştir.